mindspore.mint.nn.SiLU

- class mindspore.mint.nn.SiLU(inplace=False)[源代码]

逐元素计算SiLU激活函数。有时也被称作Swish函数。

SiLU函数定义为:

\[\text{SiLU}(x) = x * \sigma(x),\]其中 \(x_i\) 是输入的元素, \(\sigma(x)\) 是Sigmoid函数。

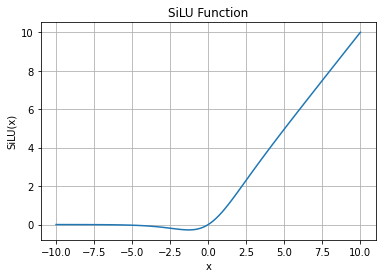

\[\text{sigmoid}(x_i) = \frac{1}{1 + \exp(-x_i)},\]SiLU函数图:

警告

这是一个实验性API,后续可能修改或删除。

- 参数:

inplace (bool, 可选) - 若为

True则启用原地更新功能。默认False。

- 输入:

input (Tensor) - 输入tensor。

- 输出:

Tensor。

- 支持平台:

Ascend

样例:

>>> import mindspore >>> input = mindspore.tensor([-1, 2, -3, 2, -1], mindspore.float16) >>> silu = mindspore.mint.nn.SiLU(inplace=False) >>> output = silu(input) >>> print(output) [-0.269 1.762 -0.1423 1.762 -0.269]